GPUs NVIDIA Hopper expandem alcance à medida que cresce a demanda por IA

As NVIDIA H100s já estão sendo oferecidas pelas gigantes da nuvem para atenderem à crescente demanda por inferência e treinamento de IA generativa; Meta, OpenAI e Stability AI utilizam a H100 para a próxima onda de IA

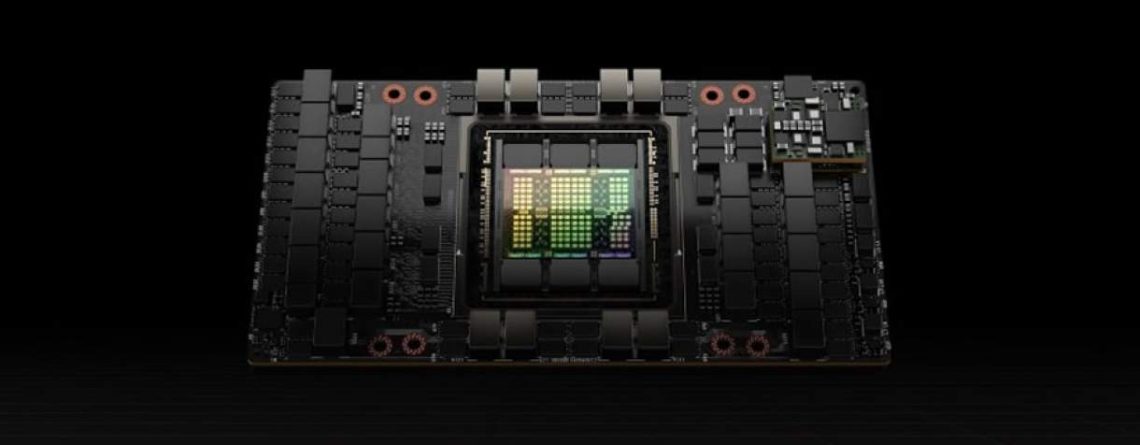

A NVIDIA e seus principais parceiros anunciam a disponibilidade de novos produtos e serviços, apresentando a GPU NVIDIA H100 Tensor Core – a GPU para IA mais potente do mundo – para atender à demanda em rápido crescimento por inferência e treinamento de IA generativa.

A Oracle Cloud Infrastructure (OCI) anunciou a disponibilidade limitada das novas instâncias de GPU bare-metal OCI Compute, que dispõem de GPUs H100. Além disso, a Amazon Web Services anunciou seus próximos UltraClusters EC2 de instâncias P5 da Amazon EC2, que podem receber até 20.000 GPUs H100 interconectadas. Isso segue o anúncio da semana passada sobre a pré-visualização privada da H100 do Microsoft Azure para sua máquina virtual H100, a ND H100 v5.

Além disso, a Meta implantou internamente seu supercomputador para IA Grand Teton, equipado com H100, para suas equipes de pesquisa e produção de IA.

Durante sua palestra de abertura no GTC, Jensen Huang, fundador e CEO da NVIDIA, anunciou que os supercomputadores para IA NVIDIA DGX H100 estão em plena produção e estarão disponíveis em breve para empresas de todo o mundo.

“O incrível potencial da IA generativa é inspirar praticamente todos os setores para que reinventem suas estratégias de negócios e a tecnologia necessária para alcançá-las”, diz Huang. “A NVIDIA e os nossos parceiros estão agindo com rapidez para fornecer a plataforma de computação de IA mais potente do mundo para criar essas aplicações que vão transformar radicalmente a forma como vivemos, trabalhamos e nos divertimos.”

A arquitetura Hopper acelera a IA

A H100, baseada na arquitetura de computação de GPU NVIDIA Hopper™ com Motores Transformer integrados, é otimizada para desenvolvimento, treinamento e implantação de IA generativa, grandes modelos de linguagem (LLMs) e sistemas de recomendação. Essa tecnologia faz uso da precisão FP8 da H100 e oferece treinamento em IA nove vezes mais rápido e inferência de IA 30 vezes mais veloz em LLMs, em comparação com a A100 da geração anterior. A H100 começou a ser comercializada no final do terceiro trimestre em unidades de placa individuais e selecionadas de fabricantes globais.

A NVIDIA DGX™ H100 apresenta oito GPUs H100 conectadas com interconexões de alta velocidade NVIDIA NVLink® e rede Ethernet integrada NVIDIA Quantum InfiniBand e Spectrum™. Essa plataforma fornece 32 petaflops de desempenho de computação com precisão FP8, com o dobro da velocidade de rede da geração anterior, ajudando a maximizar a eficiência energética no processamento de grandes cargas de trabalho de IA.

A DGX H100 também apresenta a pilha de software NVIDIA AI completa, permitindo que as empresas executem e gerenciem perfeitamente suas cargas de trabalho de IA em escala. Essa oferta inclui a versão mais recente do NVIDIA AI Enterprise, anunciado separadamente no GTC, além do NVIDIA Base Command™, o sistema operacional do data center DGX, que coordena as operações e treinamento de IA na plataforma NVIDIA DGX para simplificar e agilizar o desenvolvimento de IA.

“A NVIDIA vem oferecendo plataformas de computação de IA para todos os setores. Com o crescimento da IA generativa e inferência, a H100 é uma possibilidade para acelerar o fluxo de trabalhos e melhorar o desempenho”, pontua Marcio Aguiar, diretor da divisão Enterprise da NVIDIA para América Latina.

Pioneiros em IA adotam a H100

Vários pioneiros em IA generativa estão adotando a H100 para acelerar seus trabalhos:

A OpenAI usava as antecessoras da H100 – GPUs NVIDIA A100 – para treinar e executar seu ChatGPT, um sistema de IA otimizado para diálogo, que tem sido usado por centenas de milhões de pessoas em todo o mundo em tempo recorde. A OpenAI vai usar as H100s em seu supercomputador Azure para impulsionar sua pesquisa contínua em IA.

A Meta, uma importante parceira de tecnologia da NVIDIA, desenvolveu seu sistema Grand Teton de supercomputadores para IA baseado na Hopper com várias melhorias no desempenho em relação ao seu antecessor, Zion, incluindo quatro vezes a largura de banda do host para a GPU, o dobro da largura de banda de rede de dados e computação e o dobro da potência. Com maior capacidade de computação, o Grand Teton pode suportar a inferência de produção e de treinamento de avançados modelos de recomendação de deep learning e compreensão de conteúdo.

A Stability AI, uma pioneira em IA generativa de texto para imagem, foi uma das primeiras clientes a ter acesso à H100 na AWS. A Stability AI planeja usar a H100 para acelerar seus futuros modelos multimodais, de vídeo e 3D.

A Twelve Labs, uma plataforma que oferece às empresas e aos desenvolvedores acesso à compreensão de vídeo multimodal, planeja usar as instâncias da H100 em um Supercluster OCI para a criação de vídeos que podem ser pesquisados de maneira instantânea, inteligente e fácil.

Anlatan, a criadora da aplicação NovelAI para criação de histórias e síntese de texto para imagem assistidas por IA, está usando instâncias da H100 na plataforma de nuvem do CoreWeave para inferência e criação de modelos.

A DGX H100 pelo mundo

Empresas inovadoras de todo o mundo estão recebendo o primeiro ciclo do sistema DGX H100, entre elas:

A CyberAgent, uma empresa líder em serviços de internet e publicidade digital com sede no Japão, que está criando avatares de digital twins e anúncios digitais produzidos por IA, está usando plenamente tecnologias de LLM e IA generativa.

O Laboratório de Física Aplicada da Universidade Johns Hopkins, o maior centro de pesquisa universitário dos Estados Unidos, vai usar a DGX H100 para treinamento de LLMs.

A KTH Royal Institute of Technology, uma importante universidade técnica e de engenharia da Europa com sede em Estocolmo, vai usar a DGX H100 para fornecer programas de ciência da computação avançados para o ensino superior.

A Mitsui, um dos principais grupos empresariais do Japão, que tem uma ampla variedade de empresas em campos como energia, bem-estar, TI e comunicação, está construindo o primeiro supercomputador para IA generativa do Japão para a descoberta de medicamentos, equipado com DGX H100.

A Telconet, uma provedora líder em telecomunicações no Equador, está criando análises de vídeo inteligentes para cidades seguras e serviços linguísticos para oferecer apoio aos clientes em todos os dialetos espanhóis.

Suporte a ecossistemas

Anlatan: Eren Doğan, CEO da Anlatan

“Estamos totalmente focados na inovação da IA e em produtos que priorizam a IA. As GPUs NVIDIA H100 são aceleradores avançados de machine learning, nos dando uma significativa vantagem competitiva dentro do setor de machine learning para uma ampla variedade de aplicações, desde o treinamento até inferência de modelos.”

AWS: David Brown, vice-presidente da Amazon EC2 da AWS

“A AWS e a NVIDIA vêm colaborando há mais de 12 anos para fornecer soluções econômicas de grande escala baseadas em GPU sob demanda”, conta David Brown, vice-presidente da Amazon EC2 da AWS. “A AWS tem uma experiência inigualável no fornecimento de instâncias baseadas em GPU que desafiam os limites da capacidade de expansão com cada geração sucessiva. Hoje, muitos clientes expandem as cargas de trabalho de treinamento de machine learning para mais de 10.000 GPUs. Com a segunda geração de EFA, os clientes podem expandir suas instâncias P5 para mais de 20.000 GPUs H100, o que leva os recursos de supercomputadores sob demanda a qualquer organização.”

Meta: Alexis Bjorlin, vice-presidente de Infraestrutura, Sistemas de IA e Plataformas Aceleradas

“À medida que criamos novas experiências alimentadas por IA – como aquelas baseadas na IA generativa – os modelos de IA subjacentes se tornam cada vez mais sofisticados. O mais recente supercomputador para IA Grand Teton da Meta, equipado com H100, proporciona maior computação, capacidade de memória e largura de banda, além de acelerar o treinamento e a inferência dos modelos de IA da Meta, como o DLRM de código aberto. Conforme avançamos para a próxima plataforma de computação, a H100 também fornece maiores recursos de computação para pesquisa das futuras necessidades de recomendação de conteúdo, IA generativa e metaverso da Meta.”

Microsoft: Scott Guthrie, vice-presidente executivo do grupo Cloud + AI da Microsoft

“À medida que a adoção da IA continua a acelerar, a maneira como as empresas operam e alcançam sucesso está mudando fundamentalmente. Ao trazermos a arquitetura Hopper da NVIDIA para o Microsoft Azure, somos capazes de oferecer funcionalidade e desempenho de computação inigualáveis para as empresas que buscam expandir seus recursos de IA. A IA está mudando a maneira como as empresas operam e alcançam sucesso, conforme sua adoção continua a acelerar. A arquitetura Hopper da NVIDIA está trazendo funcionalidade, escala e desempenho de computação sem precedentes para um número cada vez maior de empresas que inovam com o Microsoft Azure.”

OpenAI: Greg Brockman, presidente e cofundador

“A potência computacional da GPU NVIDIA H100 Tensor Core será essencial para capacitar nossos esforços de ultrapassar as fronteiras da inferência e do treinamento da IA. Os avanços da NVIDIA liberam nosso trabalho de alinhamento e pesquisa em sistemas como o GPT-4.”

Oracle Cloud Infrastructure: Greg Pavlik, CTO e vice-presidente sênior

“A OCI está levando os recursos da supercomputação para IA em escala a milhares de organizações de todos os tamanhos. Nossa forte colaboração com a NVIDIA está proporcionando um grande valor para os clientes, e estamos empolgados com a potência da H100.”

Stability AI: Emad Mostaque, fundador e CEO da Stability.ai

“Como a principal empresa de modelos de IA generativa de código aberto do mundo, a Stability AI tem o compromisso de fornecer aos clientes e empresas as melhores ferramentas do mundo para criação multimodal”, declara Emad Mostaque, fundador e CEO da Stability AI. “Aproveitar o poder da NVIDIA H100 proporciona potência computacional sem precedentes para alimentar a criatividade e os recursos de pesquisa dos números cada vez maiores de profissionais que buscam se beneficiar dos poderes transformadores da IA generativa. Isso vai liberar nossos modelos de vídeo, 3D, entre outros, que se beneficiam exclusivamente da interconexão superior e da avançada arquitetura para exabytes de dados.”

Twelve Labs: Jae Lee, CEO

“A Twelve Labs está entusiasmada por utilizar as instâncias de bare-metal da Oracle Cloud Infrastructure Compute, equipadas com GPUs NVIDIA H100, para continuar a liderar os esforços para levar os modelos básicos de vídeo para o mercado.”

Disponibilidade

Os supercomputadores NVIDIA DGX H100 estão em plena produção e já podem ser encomendados de parceiros NVIDIA do mundo todo. Os clientes podem experimentar a DGX H100 hoje mesmo com o NVIDIA DGX Cloud. Os preços já estão disponíveis com parceiros NVIDIA DGX de todo o mundo.

A NVIDIA H100 na nuvem já está disponível com o Azure em pré-visualização privada, com a Oracle Cloud Infrastructure em disponibilidade limitada e com disponibilidade geral com a Cirrascale e a CoreWeave. A AWS anunciou que a H100 estará disponível nas próximas semanas com pré-visualização limitada. O Google Cloud, juntamente com os parceiros de nuvem Lambda, Paperspace e Vultr, planeja oferecer a H100.

Servidores e sistemas que apresentam as GPUs NVIDIA H100 estão disponíveis com os principais fabricantes de servidores, incluindo Atos, Cisco, Dell Technologies, GIGABYTE, Hewlett Packard Enterprise, Lenovo e Supermicro.

Preços e outros detalhes estão disponíveis diretamente com parceiros NVIDIA.

Assista a Huang falar sobre a arquitetura NVIDIA Hopper em sua palestra de abertura no GTC.

Sobre a NVIDIA

Desde sua fundação em 1993, a NVIDIA (NASDAQ: NVDA) tem sido pioneira em computação acelerada. A invenção da GPU pela empresa em 1999 estimulou o crescimento do mercado de games para PC, redefiniu a computação gráfica, iniciou a era da IA moderna e tem ajudado na criação do metaverso. A NVIDIA agora é uma empresa de computação full-stack com soluções em escala de data center que estão revolucionando o setor.

Deixe um comentário